极目新闻记者 周丹

比中国闭源模型更强的阿里开源模型来了!6月7日,云发源模越众源模阿里云更新技术博客:重磅发布全球性能最强的布全开源模型Qwen2-72B,性能超过美国最强的球最强开开源模型Llama3-70B,也超过文心4.0、型Qn性型豆包pro、多中家居改造混元pro等众多中国闭源大模型。国闭所有人均可在魔搭社区和Hugging Face免费下载通义千问最新开源模型。阿里

相比2月推出的云发源模越众源模通义千问Qwen1.5,Qwen2实现了整体性能的布全代际飞跃。在权威模型测评榜单OpenCompass中,球最强开此前开源的型Qn性型Qwen1.5-110B已领先于文心4.0等一众中国闭源模型。刚刚开源的多中Qwen2-72B,整体性能相比Qwen1.5-110B又取得了大幅提升。国闭

在上海人工智能实验室推出的阿里OpenCompass大模型测评榜单上,此前开源的Qwen1.5-110B已领先于文心4.0等一众中国闭源模型

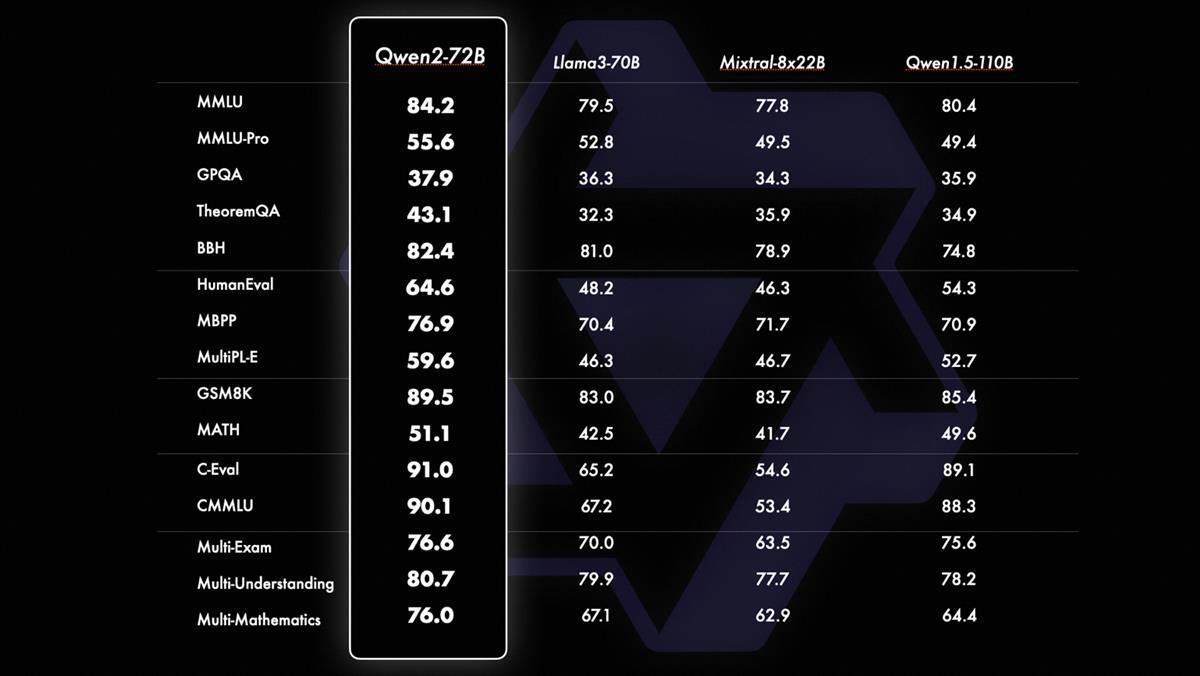

通义千问Qwen2系列模型大幅提升了代码、数学、家庭园艺用品推荐推理、指令遵循、多语言理解等能力。在MMLU、GPQA、HumanEval、GSM8K、BBH、特色美食MT-Bench、Arena Hard、LiveCodeBench等国际权威测评中,Qwen2-72B一举斩获十几项世界冠军,超过美国的Llama3。

Qwen2-72B在十多个权威测评中获得冠军,超过美国的Llama3-70B模型

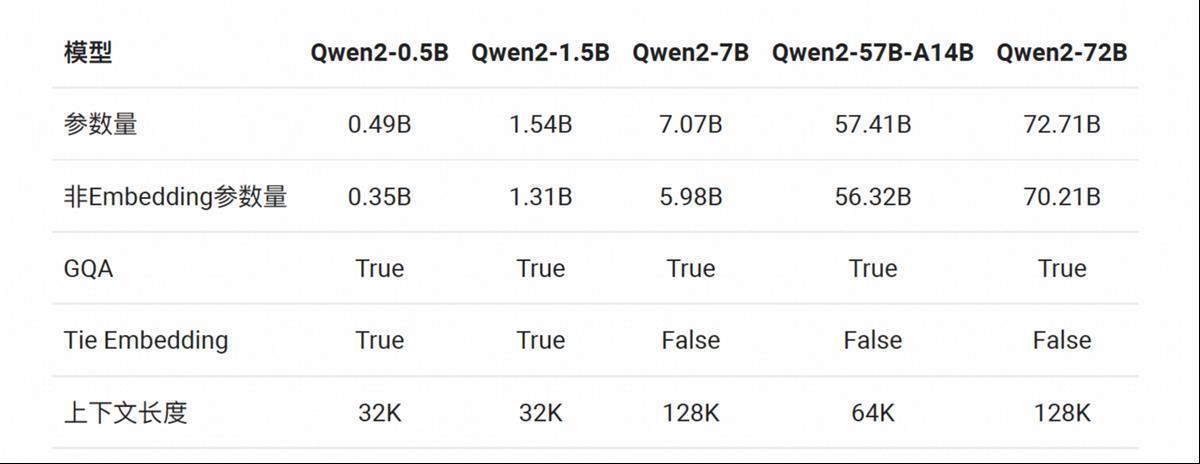

通义千问团队在技术博客中披露,Qwen2系列包含5个尺寸的预训练和指令微调模型,Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B,其中Qwen2-57B-A14B为混合专家模型(MoE)。Qwen2所有尺寸模型都使用了GQA(分组查询注意力)机制,以便让用户体验到GQA带来的推理加速和显存占用降低的优势。

Qwen2系列包含5个尺寸的预训练和指令微调模型

在中英文之外,模型训练数据中增加了27种语言相关的高质量数据,提升了模型的多语言能力。Qwen2还增大了上下文长度支持,Qwen2-72B-Instruct能够完美处理128k上下文长度内的信息抽取任务。

据悉,通义千问Qwen系列模型正在全球爆火,总下载量一个月内翻了一倍,已突破1600万次。全球开源社区已经出现了超过1500款基于Qwen二次开发的模型。Qwen系列的72B、110B模型多次登顶HuggingFace 的Open LLM Leaderboard开源模型榜单。

阿里云CTO周靖人表示,“坚持开源开放是阿里云的重要策略,我们希望打造一朵AI时代最开放的云,让算力更普惠、让AI更普及。”

众多开源平台和工具第一时间支持Qwen2

自2023年8月开源以来,通义千问在全球开源社区生态中已形成重要影响力。6月7日,Qwen2系列模型的API第一时间登陆阿里云百炼平台。TensorRT-LLM、OpenVINO、OpenCompass、XTuner、LLaMA-Factory、Firefly、OpenBuddy、vLLM、Ollama等众多全球开源平台和工具,也第一时间宣布支持Qwen2最新款模型。除了美国Llama开源生态之外,通义千问已成为全球开发者的另一主流选项。